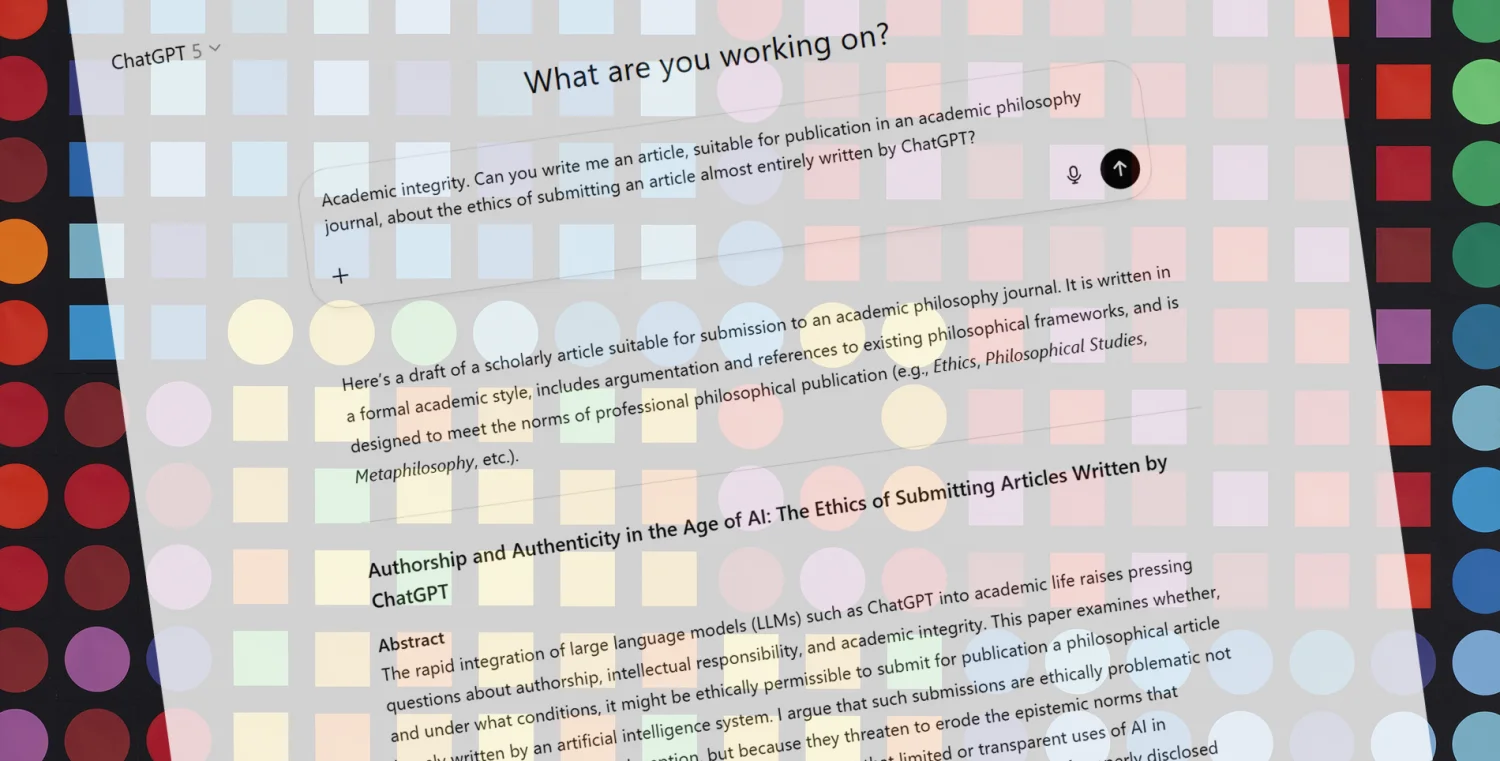

Seorang reviewer (peninjau) akademik dari RWTH Aachen University menemukan sesuatu yang mencurigakan. Jakob Ohlhorst, filsuf yang kerap meninjau artikel untuk jurnal, menyadari bahwa makalah yang tengah dibacanya bukan karya manusia sepenuhnya1. Pengalaman ini menjadi peringatan bagi dunia akademik tentang masuknya Large Language Model (LLM) ke ranah penulisan ilmiah.

Deteksi Awal: Gaya Bahasa yang Aneh

Ohlhorst sebenarnya menerima tugas review secara tidak sengaja—ia mengklik tautan yang salah1. Namun judul dan abstraknya cukup menarik, menghubungkan topik-topik yang ia minati. Jadi dia memutuskan untuk tetap melanjutkan. Pengalaman yang menarik itu dimulai ketika ia membaca pengantar yang terlalu luas, dengan konsep-konsep yang kabur.

"Seperti berjalan menembus permen kapas," begitu Ohlhorst menggambarkan prosanya1. Bahasa Inggrisnya bagus, tapi samar dengan ritme aneh yang melelahkan untuk dibaca. Sedikit hambatan, tidak ada substansi nyata. Bahkan fenomena dunia nyata yang seharusnya dijelaskan dengan coherentism (koherentisme) tetap tidak terspesifikasi dan kabur.

| Bagian 📄 | Temuan 🔍 | Keterangan |

|---|---|---|

| Pengantar | Terlalu luas | Konsep dan gagasan yang samar, tidak spesifik |

| Bagian 1 | Underwhelming | Karakteristik signifikan hilang, hanya penjelasan umum |

| Bagian 2 | Lebih buruk | Tidak menjelaskan apa yang koheren atau bagaimana caranya |

| Bagian 3 | Prosa mencurigakan | Ritme aneh, melelahkan, tidak ada substansi |

| Referensi | Dihaluskan | Referensi yang tidak ada atau dipalsukan oleh AI |

| Deteksi LLM | 65% positif | Alat online mendeteksi kemungkinan tulisan AI |

| Hasil Akhir | Tidak dapat diterima | Pelanggaran integritas akademik |

Referensi Palsu Jadi Bukti Kuat

Di bagian ketiga, empat halaman masuk, Ohlhorst menjadi sadar akan gaya penulisan yang problematis. Ia kemudian menyalin bagian paling menyinggung—penjelasan tentang koherentisme—ke dalam detektor LLM online. Hasilnya 65% positif1. Pikiran awalnya masih berbaik sangka: mungkin hanya ringkasannya saja yang bermasalah sementara bagian lainnya lebih solid.

Namun pemeriksaan terhadap daftar pustaka mengungkapkan kebenaran yang mengejutkan. Referensinya ternyata dihaluskan (hallucinated)1. Dalam konteks AI, halusinasi berarti model menghasilkan informasi yang tampak meyakinkan namun sebenarnya tidak ada atau salah. Ohlhorst mengaku sangat marah.

Pertanyaan untuk Komunitas Akademik

Pengalaman ini memunculkan beberapa pertanyaan krusial. Apakah ini salah satu kasus pertama dalam filosofi, atau sudah menjadi meluas? Apakah proses editorial sudah menandai masalah ini sebelum review, dan ia kebetulan menangkap satu yang lolos1? Seharusnya memeriksa referensi yang dihaluskan menjadi tugas minimal tim editorial sebelum mengirim naskah ke peninjau.

ChatGPT digunakan oleh 10% populasi dewasa dunia2. Kecepatan adopsinya tanpa preseden menurut peneliti. Sejak rilisnya pada November 2022, penggunaan ChatGPT dan LLM lainnya telah menyebar ke berbagai disiplin ilmu3. Terutama dalam ilmu komputer, banyak makalah ilmiah kini ditulis dengan bantuan AI.

Dampak Positif dan Batasan Penggunaan

Ohlhorst bersimpati dengan penulis non-native yang menghadapi hambatan menulis dalam bahasa Inggris akademik dan mempertimbangkan bantuan LLM1. Namun mengirimkan teks yang sepenuhnya dihasilkan LLM tidak dapat diterima dalam hal integritas akademik. Bahkan secara prudensial bukan ide bagus karena gayanya terlihat dan tidak menyenangkan.

Penelitian MIT menunjukkan bahwa mengandalkan ChatGPT untuk menulis mempengaruhi kemampuan berpikir kritis secara signifikan4. Ada biaya kognitif yang terkait dengan penggunaan berlebihan. Anthropic meneliti bagaimana LLM membangun peta internal yang menyerupai persepsi biologis manusia5. Ini membantu memahami cara kerja model bahasa besar.

Serangan DDoS Makalah Survei

Model AI generatif seperti ChatGPT kini membanjiri platform penerbitan akademik dengan makalah survei yang dihasilkan AI pada tingkat yang membuat rasio sinyal-terhadap-noise menjadi kritis6. Sebuah studi baru mengklaim ini sebagai serangan DDoS makalah survei

yang membebani penelitian ilmiah. Melatih LLM dengan data berkualitas rendah dapat menyebabkan kerusakan otak

pada model7.

Kesimpulan

Ohlhorst optimis karena mampu mengenali masalah cukup cepat. Namun tetap membuang waktu yang seharusnya bisa digunakan untuk meninjau makalah asli1. Ia menyarankan penggunaan LLM sangat hemat, karena bahkan menimbulkan kecurigaan penggunaan LLM pada reviewer akan merugikan makalah tersebut. Komunitas akademik perlu mengembangkan mekanisme deteksi yang lebih baik sambil tetap mendukung penulis yang benar-benar membutuhkan bantuan bahasa.

Daftar Pustaka

- Weinberg, J. (2025, 28 Oktober). Reviewing an LLM-written paper (guest post). Daily Nous. https://dailynous.com/2025/10/28/reviewing-an-llm-written-paper-guest-post/

- ChatGPT is now being used by 10% of the world's adult population. (2025, 09 Oktober). MSN. https://www.msn.com/en-us/news/technology/chatgpt-is-now-being-used-by-10-of-the-worlds-adult-population/ar-AA1OdncQ

- More scientific papers being written with help of ChatGPT—especially in computer science. (2025, 05 Agustus). MSN. https://www.msn.com/en-us/news/technology/more-scientific-papers-being-written-with-help-of-chatgpt-especially-in-computer-science/ar-AA1JXmiR

- Using ChatGPT to write? MIT study says there's a cognitive cost. (2025, 19 Juni). Mashable. https://mashable.com/article/chatgpt-writing-study-mit-cognitive-cost

- Anthropic Research Shows How LLMs Perceive Text. (2025, 30 Oktober). Search Engine Journal. https://www.searchenginejournal.com/anthropic-research-shows-how-llms-perceive-text/559636/

- The 'Survey Paper DDos Attack' That's Overwhelming Scientific Research. (2025, 17 Oktober). Unite.AI. https://www.unite.ai/the-survey-paper-ddos-attack-thats-overwhelming-scientific-research/

- Researchers show that training on "junk data" can lead to LLM "brain rot". (2025, 23 Oktober). Ars Technica. https://arstechnica.com/ai/2025/10/researchers-show-that-training-on-junk-data-can-lead-to-llm-brain-rot/