Inference (inferensi) menjadi lapisan operasional yang mengubah investasi AI menjadi nilai bisnis nyata. Craig Partridge dari HPE menegaskan "nilai sejati AI terletak pada inference"1, bukan sekadar pelatihan model. Artikel ini mengupas bagaimana organisasi global menerapkan AI dalam skala produksi untuk menghasilkan return on investment (ROI) maksimal.

Kepercayaan sebagai Fondasi AI Berskala Tinggi

Christian Reichenbach, worldwide digital advisor HPE, mengungkap hasil survei terhadap 1.775 pemimpin IT: 22% organisasi telah mengoperasionalkan AI—naik dari 15% tahun sebelumnya1. Mayoritas masih terjebak eksperimen. Mencapai tahap berikutnya butuh tiga pendekatan: kepercayaan sebagai prinsip operasional, eksekusi berpusat data, kepemimpinan IT yang mampu menskalakan AI dengan sukses.

Trusted inference (inferensi tepercaya) memungkinkan pengguna mengandalkan jawaban sistem AI sepenuhnya. Penting untuk aplikasi seperti generasi konten pemasaran dan chatbot customer service (layanan pelanggan), namun krusial untuk skenario berisiko tinggi—robot bedah atau kendaraan otonom di jalan ramai1. Reichenbach mencontohkan ketika kualitas data menurun: konten AI tidak andal termasuk halusinasi, memaksa karyawan habis waktu untuk verifikasi fakta.

| Aspek 🎯 | Kondisi Tanpa Kepercayaan ⚠️ | Kondisi Dengan Kepercayaan ✅ |

|---|---|---|

| Kualitas Data | Data buruk menghasilkan inferensi buruk | Fondasi andal untuk hasil akurat |

| Produktivitas | Waktu terbuang untuk verifikasi | Efisiensi dan produktivitas meningkat |

| Kepercayaan Tim | Turun drastis saat kesalahan terjadi | Copilot andal 24/7 untuk tim |

| Operasional Jaringan | Konfigurasi manual lambat | Rekomendasi cepat dan akurat |

| Hasil Bisnis | Target tidak tercapai | Transformasi bisnis nyata |

| Konten AI | Halusinasi dan kesalahan | Output berkualitas tinggi |

| Adopsi Teknologi | Terhambat karena keraguan | Akselerasi implementasi |

Evolusi dari Model-Sentris ke Data-Sentris

Era Baru AI Factory

Lima tahun terakhir menunjukkan pergeseran signifikan. "Yang lebih bermakna adalah menghancurkan silo data, mengakses aliran data, dan membuka nilai dengan cepat," ujar Reichenbach1. Evolusi terjadi beriringan dengan munculnya AI factory (pabrik AI)—jalur produksi always-on di mana data bergerak melalui pipeline dan feedback loop menghasilkan intelijen kontinu.

Nvidia mempersiapkan pertumbuhan eksponensial dalam AI inference, fokus memberikan performa per watt lebih baik untuk memicu ledakan AI2. Groq dan Equinix meluncurkan hub AI regional di Australia, menawarkan inference berkecepatan tinggi lebih cepat dan kepatuhan data lebih kuat untuk pengguna di Indonesia3. GMI Cloud mengumumkan kemitraan dengan Nvidia untuk membangun AI Factory generasi baru di Taiwan, didukung investasi US$500 juta4.

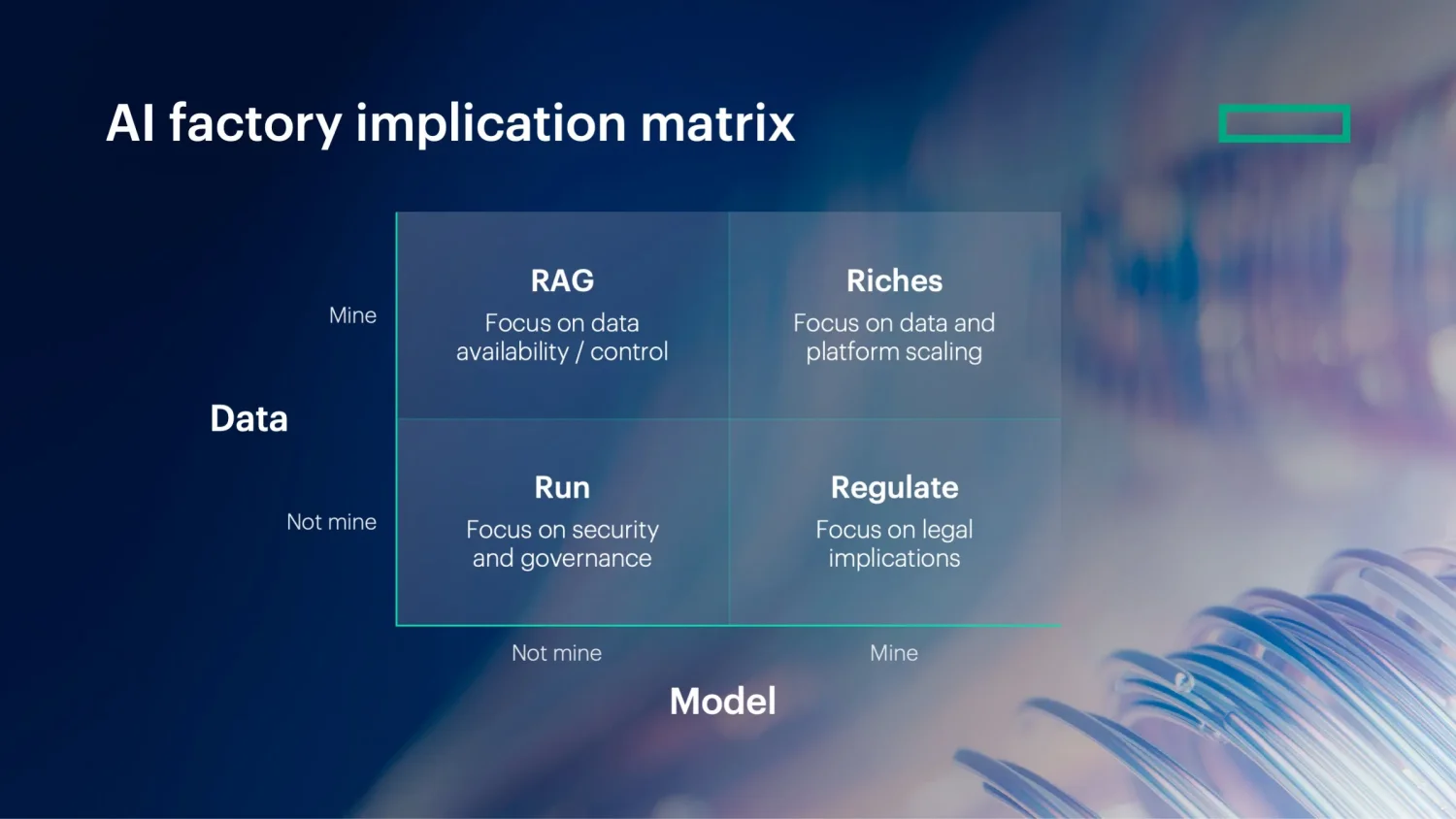

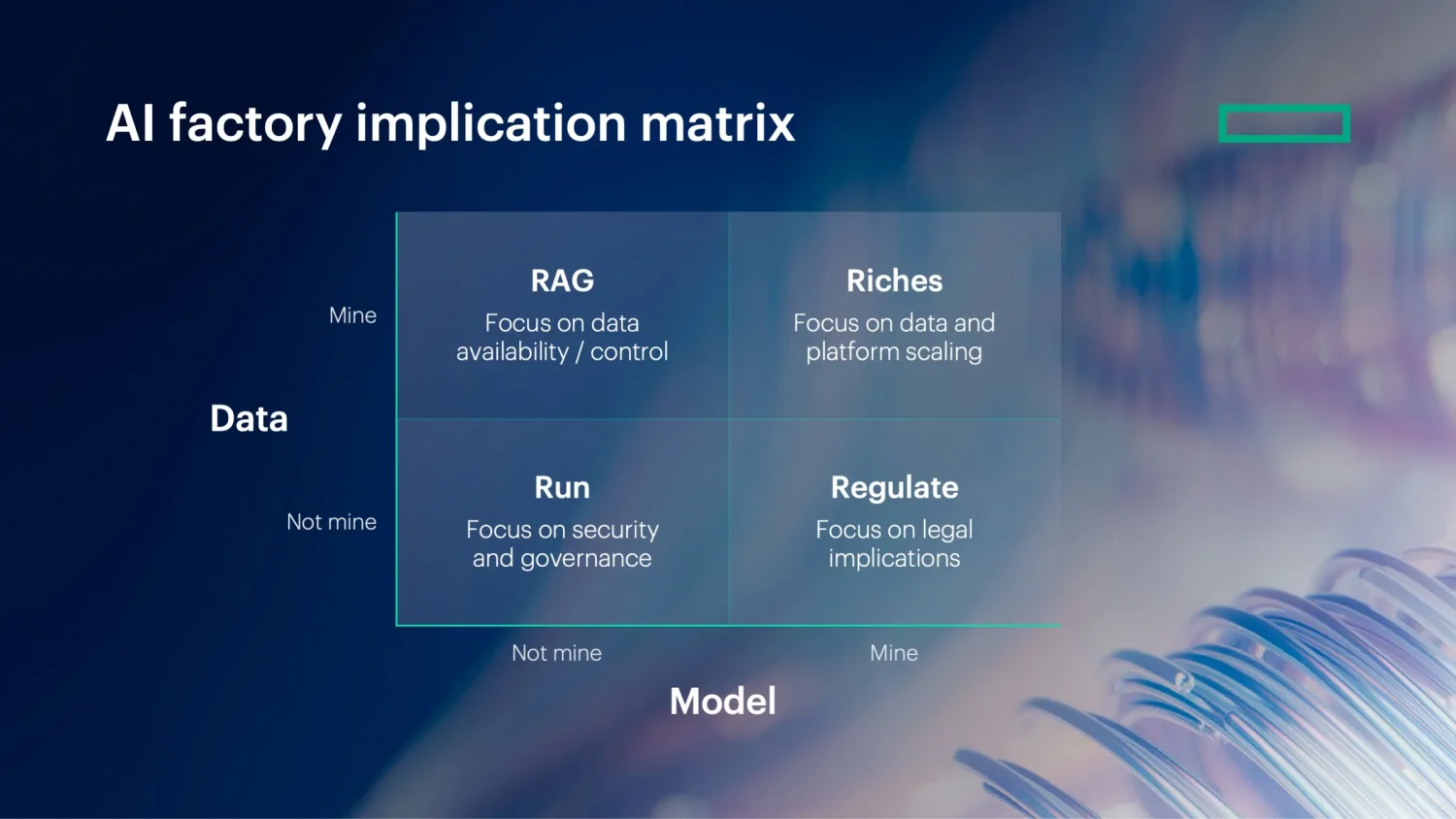

Matriks Implikasi AI Factory HPE

Reichenbach menjelaskan dua pertanyaan sentral: "Seberapa banyak intelijen—model itu sendiri—yang benar-benar milik Anda? Seberapa banyak input—data—yang unik milik Anda, dari pelanggan, operasi, atau pasar?"1 Partridge membagi empat kuadran:

- Run: Mengakses model pretrained eksternal via interface atau API; organisasi tidak memiliki model atau data. Implementasi butuh keamanan dan tata kelola kuat plus pusat keunggulan yang membuat dan mengomunikasikan keputusan penggunaan AI1.

- RAG (Retrieval Augmented Generation): Menggunakan model pretrained eksternal dikombinasikan data proprietary perusahaan untuk menghasilkan wawasan unik. Implementasi fokus menghubungkan aliran data ke kapabilitas inferensi yang menyediakan akses cepat dan terintegrasi ke platform AI full-stack1.

- Riches: Melatih model kustom pada data yang berada dalam perusahaan untuk peluang diferensiasi dan wawasan unik. Implementasi memerlukan lingkungan terukur hemat energi, sering kali sistem high-performance1.

- Regulate: Memanfaatkan model kustom dilatih pada data eksternal, memerlukan pengaturan terukur sama seperti Riches, tetapi dengan fokus tambahan pada kepatuhan hukum dan regulasi untuk menangani data sensitif non-milik dengan sangat hati-hati1.

Kuadran ini tidak saling eksklusif. Partridge mencatat kebanyakan organisasi—termasuk HPE sendiri—beroperasi di banyak kuadran1.

Kepemimpinan IT dalam Menskalakan AI

"Ada nilai dalam eksperimen dan melempar ide," kata Partridge. "Tapi jika ingin benar-benar melihat manfaat AI, itu harus sesuatu yang semua orang bisa libatkan dan memecahkan banyak use case berbeda"1. Tantangan mengubah proyek rintisan butik menjadi sistem organisasi-lebar cocok dengan kompetensi inti fungsi IT.

Sejarah menawarkan kisah peringatan dari pergeseran infrastruktur besar terakhir: migrasi perusahaan ke cloud. Banyak departemen IT duduk di luar pengambilan keputusan selama gelombang adopsi cloud awal dekade lalu, sementara unit bisnis secara independen menerapkan layanan cloud1. Ini menghasilkan sistem terfragmentasi, pengeluaran berlebihan, celah keamanan yang butuh bertahun-tahun untuk diurai. Dinamika sama mengancam terulang dengan AI sebagai shadow AI—lingkungan di mana uji coba berkembang tanpa pengawasan atau tata kelola.

Google, Microsoft, AWS, dan Oracle Cloud Infrastructure mempercepat inferensi AI untuk pelanggan mereka dengan platform perangkat lunak Nvidia Dynamo5. Cloud-native computing (komputasi asli-awan) siap meledak berkat pekerjaan AI inference, dengan CNCF optimis tentang kolaborasi cloud-native dengan AI6.

Kesimpulan

Reichenbach merangkum apa yang dibutuhkan kesuksesan: "Ini bermuara pada mengetahui di mana Anda bermain: Kapan menjalankan model eksternal lebih cerdas, kapan menerapkan RAG untuk membuatnya lebih terinformasi, di mana berinvestasi untuk membuka Riches dari data dan model Anda sendiri, dan kapan Regulate apa yang tidak Anda kontrol. Pemenangnya adalah mereka yang membawa kejelasan ke semua kuadran dan menyelaraskan ambisi teknologi dengan tata kelola dan penciptaan nilai"1. Perjalanan menuju AI produksi memerlukan kepercayaan, arsitektur data kuat, dan kepemimpinan IT proaktif yang tidak takut mengambil peran strategis dalam transformasi organisasi.

Daftar Pustaka

- MIT Technology Review Insights. "Realizing value with AI inference at scale and in production." MIT Technology Review, 18 November 2025. https://www.technologyreview.com/2025/11/18/1128007/realizing-value-with-ai-inference-at-scale-and-in-production/

- "Nvidia prepares for exponential growth in AI inference." Computer Weekly, 20 November 2025. https://www.computerweekly.com/news/366634622/Nvidia-prepares-for-exponential-growth-in-AI-inference

- "Australia Launches Regional AI Hub With Groq–Equinix Collaboration, Bringing Faster Compute to Indonesia." Jakarta Globe, 16 November 2025. https://jakartaglobe.id/tech/australia-launches-regional-ai-hub-with-groqequinix-collaboration-bringing-faster-compute-to-indonesia

- "GMI Cloud Launches Next-Generation AI Factory in Taiwan." The Manila Times, 18 November 2025. https://www.manilatimes.net/2025/11/19/tmt-newswire/pr-newswire/gmi-cloud-launches-next-generation-ai-factory-in-taiwan/2227088

- "Google, Microsoft among those boosting AI inference performance for cloud customers using Nvidia's software Dynamo." MSN, 14 November 2025. https://www.msn.com/en-us/news/technology/google-microsoft-among-those-boosting-ai-inference-performance-for-cloud-customers-using-nvidias-software-dynamo/ar-AA1Qr4Lu

- "Cloud-native computing is poised to explode, thanks to AI inference work." MSN, 18 November 2025. https://www.msn.com/en-us/news/technology/cloud-native-computing-is-poised-to-explode-thanks-to-ai-inference-work/ar-AA1QHb50